Perspectivas globales sobre regulaciones en Inteligencia Artificial

En el contexto actual, nos enfrentamos a una encrucijada donde la tensión entre los intereses de las empresas, especialmente las de tecnología, y las preocupaciones atribuidas a la proliferación de la IA, se torna evidente. En esta nueva era, la Inteligencia Artificial (IA) no solo está incidiendo profundamente en el desarrollo de nuestra sociedad y economía, sino que está dando lugar a desafíos significativos que requieren atención inmediata. Si bien, es innegable el potencial de la IA como aspecto clave en el desarrollo de nueva tecnología, no podemos ignorar las preocupaciones asociadas con su creciente influencia en todas las dimensiones de la vida humana (Barrera, 2024). En este sentido, la necesidad de generar marcos regulatorios legales efectivos, surge para abordar tanto las oportunidades como los riesgos que presenta la IA.

Cabe preguntarse ¿Qué sucedería si una IA discrimina a un usuario en una decisión automatizada? Por ejemplo, en el 2015, una afroamericana, cuando miró su fotografía en la aplicación de Google Photos encontró que el software de reconocimiento facial la había etiquetado con la palabra “gorila”. Esto sucedió porque el algoritmo no había sido entrenado con suficientes imágenes de personas afro, dejando en evidencia un sesgo algorítmico racial. El sesgo algorítmico será un problema cada vez mayor a medida que las decisiones de estos softwares se vuelvan cada vez más importantes en nuestras vidas (Morales C, 2020).

Ahora bien, pensemos cómo esta situación se vuelve más angustiante cuando las decisiones automatizadas de las IA afectan los derechos fundamentales de las personas. En el mundo, cada vez más, encontramos ejemplos de cómo los bancos y otras instituciones están utilizando programas de IA que automatizan las decisiones de las vidas de las personas. Un ejemplo claro de esto es el programa estadounidense COMPAS (por sus siglas en inglés). Este programa es básicamente una herramienta que genera perfiles en base a un cuestionario que se le da a las personas que han sido arrestadas. Las preguntas incluyen aspectos como antecedentes penales, tanto del reo como de sus familiares, su domicilio y sus datos académicos, así la IA determina si esa persona en el futuro podría cometer un crimen. Entonces, concluye, según su puntuación de riesgo, si alguien debe entrar en prisión o salir en libertad condicional, o el tiempo que debe permanecer en la cárcel. Sin embargo, Dressel & Farid (2018), estudiaron la validez de los resultados de COMPAS, y demostraron que el algoritmo no es más fiable que cualquier humano sin preparación o experiencia en justicia penal.

Evidenciamos entonces que en algunos casos, la elaboración de perfiles por parte de la IA puede llevar a predicciones inexactas. En escenarios más severos, puede ocasionar a la negación de servicios y bienes, y a una discriminación injustificada. Constatando que las tecnologías basadas en IA están transgrediendo los derechos humanos en determinadas circunstancias. Por ende, es importante la implementación de regulaciones apropiadas y oportunas para asegurar que la IA se emplee de manera ética, segura y responsable.

Inicialmente, las recomendaciones éticas, sugeridas por instituciones como la UNESCO y otros organismos internacionales, han servido como punto de partida fundamental, proporcionando orientación en la materia. Vemos como en 2021, la UNESCO lanzó su Recomendación sobre la Ética de la Inteligencia Artificial, para promover un enfoque inclusivo y ético, en el desarrollo y uso de estos sistemas de IA. Algunos puntos clave de esta recomendación incluyen:

- Promover la igualdad y la no discriminación en el diseño y aplicación de sistemas de IA.

- Garantizar la transparencia y rendición de cuentas en el uso de algoritmos y datos con los que se entrenaron.

- Fomentar la participación pública en la toma de decisiones relacionadas con la IA.

- Proteger la privacidad y la seguridad de los datos de los usuarios.

- Salvaguardar la diversidad cultural y lingüística en el desarrollo de sistemas de IA.

No obstante, los desafíos y las dinámicas, relacionados con el desarrollo de las tecnologías digitales, requieren más que reducir los riesgos. Como bien señala el adagio popular: “Del dicho al hecho hay mucho trecho”, la transposición de estas recomendaciones éticas de la UNESCO en leyes y regulaciones concretas representa un desafío considerable. Entonces, surge la pregunta: ¿Cómo se pueden aterrizar estas recomendaciones? ¿Cómo se pueden definir las responsabilidades de los diferentes actores?

De las recomendaciones al marco jurídico

Para mayo de 2023, en Estados Unidos, Hollywood se convirtió en un escenario importante para la demanda de una mayor regulación sobre la propiedad intelectual. El sindicato de guionistas logró el primer contrato que les garantiza protección frente a las tecnologías basadas en IA en rápido desarrollo. Este hito tuvo un impacto notable en la industria del entretenimiento y puso de manifiesto los desafíos que plantea la IA en términos de derechos de autor y propiedad intelectual, especialmente en el uso de la IA para generar contenido creativo (Duran, 2023).

Según el Índice Internacional de Propiedad Intelectual de la Cámara de Comercio de EEUU (2024), Estados Unidos es quién lidera el mundo en la protección de los derechos de propiedad intelectual, incluyendo patentes, derechos de autor y marcas registradas. Sin embargo, aún para EEUU es notoria la necesidad de abordar la relación entre la IA y la propiedad intelectual. Es crucial encontrar un equilibrio entre la promoción de la innovación y la protección de los derechos creativos. En este sentido, Hollywood ha sido un campo de acción importante en esta lucha, y su experiencia podría servir como ejemplo para otros gremios y profesiones en el futuro.

Para abril de 2021, la Comisión Europea propuso el primer marco regulador de la Unión Europea (UE) para la Inteligencia Artificial, que finalmente se concretó en 2024 como la ley de Inteligencia Artificial de la UE (ACT IA), donde resulta notable el enfoque planteado, basado en la evaluación de riesgos y los posibles impactos asociados con diversos sistemas basados en IA. La pregunta fundamental que surge entonces es: ¿Qué es considerado como un riesgo en este nuevo contexto tecnológico?

En esta ley se identifican áreas de alto riesgo y áreas de bajo riesgo, entre las cuales a su vez se clasifican entre riesgo limitado y riesgo mínimo. Los sistemas que podrían tener impacto negativo en la salud, la seguridad y los derechos fundamentales, se consideran de alto riesgo, como los sistemas de identificación biométrica remota (reconocimiento facial) en espacios públicos, que solo podrían utilizar las autoridades policiales en casos específicos. Mientras que los sistemas que no influyen sustancialmente en el resultado de la toma de decisiones se consideran de bajo riesgo, como un sistema de IA que transforme datos no estructurados en datos estructurados, un sistema de IA que clasifique en categorías los documentos recibidos o un sistema de IA que se utilice para detectar duplicados entre un gran número de aplicaciones, son considerados de riesgo limitado. Al igual que los sistemas de IA destinados a mejorar el resultado de una actividad previa llevada a cabo por un ser humano, como los sistemas de IA destinados a mejorar el lenguaje utilizado en documentos ya redactados, por ejemplo, en lo referente al empleo de un tono profesional o de un registro lingüístico académico o a la adaptación del texto a una determinada comunicación de marca, son considerados un riesgo menor.

El enfoque principal radica en la ciberseguridad y la protección de la privacidad de la información. El propósito del reglamento es asegurar que los sistemas de IA empleados en la Unión Europea sean seguros y confiables, para lo cual se han establecido regulaciones rigurosas. Los sistemas de IA de riesgo inaceptables están prohibidos, mientras que aquellos con un alto riesgo deben someterse a un protocolo de evaluación y satisfacer ciertos requisitos antes de su introducción al mercado. Se espera que esta legislación pionera se convierta en un referente global, incentivando la adopción de un enfoque similar a nivel mundial.

Además, la normativa prevé la creación de la Oficina Europea de Inteligencia Artificial, la cual coordinará el uso de las tecnologías basadas en IA entre las autoridades nacionales. Se crea como centro de conocimientos especializados en IA y constituye la base de un único sistema europeo de gobernanza de esta.

Por otro lado, el panorama actual de las políticas públicas que promueven la IA en Latinoamérica se encuentra en pleno debate sobre los posibles mecanismos regulatorios. Aunque se alinea con las tendencias internacionales, se están realizando considerables esfuerzos para desarrollar principios y normas para las tecnologías basadas en IA, en especial la integración con la ley de protección de datos personales (Veronese & Nunes, 2021). Numerosas iniciativas para la regulación de la IA se están convirtiendo en planes nacionales, políticas o estrategias en varios países. Además, se están haciendo grandes esfuerzos para crear una red de cooperación más amplia a un nivel regional. Por ejemplo, podemos mencionar a la Comisión Económica para Latinoamérica y el Caribe (CEPAL) de las Naciones Unidas, que está tratando de impulsar este movimiento conjunto.

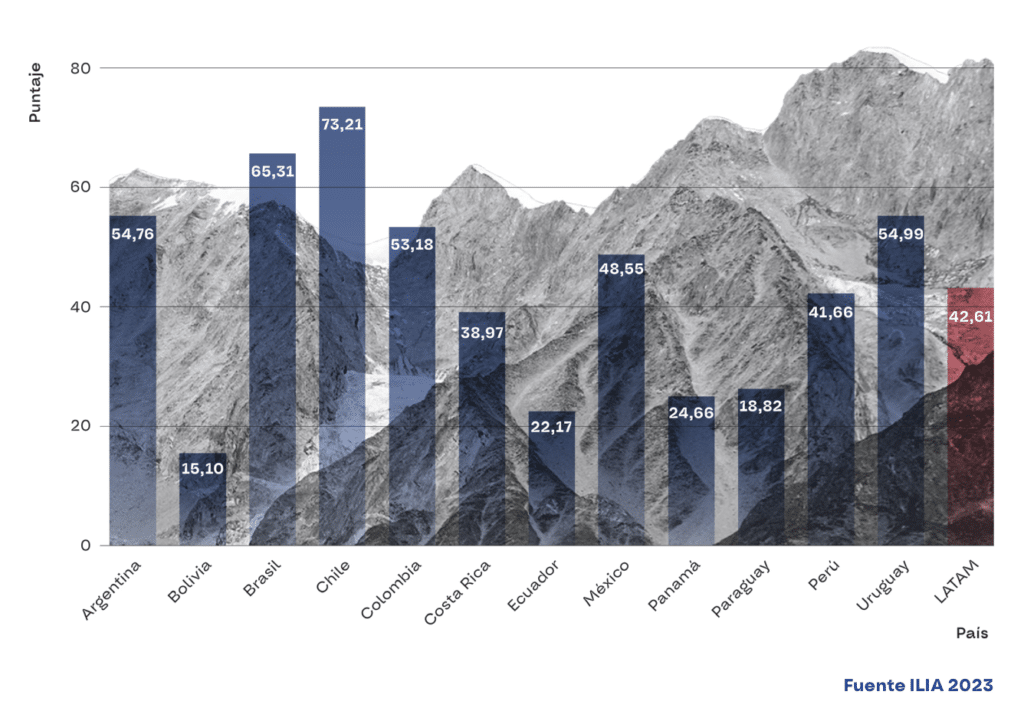

En este contexto, surge el Índice Latinoamericano de Inteligencia Artificial (ILIA), elaborado por el Centro Nacional de Inteligencia Artificial de Chile (CENIA). Este índice, presentado en 2023 por la CEPAL en colaboración con diversas instituciones regionales y globales, representa el primer estudio público regional en la materia. Ofrece un diagnóstico integral y actualizado sobre el estado de la IA en 12 países latinoamericanos, identificando brechas, niveles de desarrollo y desafíos comunes.

Para la elaboración de este índice, se identificaron tres dimensiones que componen el ecosistema de IA: 1. Factores habilitantes, 2. Investigación, desarrollo y adopción, y 3. Gobernanza. Estas dimensiones buscan revelar las capacidades instaladas en infraestructura, capital humano, datos, regulaciones, entre otros aspectos.

Todos los indicadores fueron recodificados en una escala de 0 a 100 para asignar puntaje y hacerlos comparables a nivel regional. La siguiente gráfica presenta los puntajes finales de cada uno de los países analizados:

Las primeras posiciones son ocupadas por Chile, Brasil y Uruguay, respectivamente, destacando su posición prominente en el contexto regional. Mientras que Colombia se encuentra en el sexto puesto de esta clasificación. Este panorama nos invita a reflexionar sobre el estado actual y las tendencias futuras en el ámbito de la IA en la región.

En el análisis anterior, se subraya la importancia de avanzar desde investigaciones, diagnósticos y recomendaciones éticas hacia marcos jurídicos cada vez más sólidos, de acuerdo con las adaptaciones particulares para cada país. Este progreso se presenta como una necesidad para regular de manera efectiva el uso de la IA, especialmente a la luz de las problemáticas surgidas por la falta de regulación en el pasado, como observamos en el ámbito de las redes sociales y las aplicaciones móviles.

Las recomendaciones éticas han proporcionado un punto de partida valioso en la reflexión sobre los principios fundamentales que deben guiar el desarrollo y la implementación de la IA. Sin embargo, su eficacia puede ser limitada si no se cuenta con el respaldo de marcos jurídicos que garanticen su aplicación y cumplimiento. Este tránsito a una regulación más sólida no implica desestimar por completo las recomendaciones éticas, sino más bien complementarlas con mecanismos legales que brinden un marco robusto para abordar los desafíos éticos y sociales asociados con estas tecnologías.

La experiencia pasada con una regulación insuficiente de tecnologías emergentes ha sido esclarecedora en diversos aspectos, poniendo de manifiesto los riesgos inherentes y los dilemas éticos que pueden derivarse cuando la velocidad de avance tecnológico supera el desarrollo normativo correspondiente. Incidentes relacionados con la manipulación de datos, la difusión de desinformación y la vulneración de la privacidad de los usuarios han ilustrado claramente la urgente necesidad de una acción proactiva en la regulación de tecnologías emergentes, como las tecnologías basadas en IA.

El escándalo de Cambridge Analytica en 2018 es un claro ejemplo de los peligros que pueden surgir cuando las tecnologías emergentes no están adecuadamente reguladas. Esta compañía utilizó los datos de Facebook de los usuarios estadounidenses para influir en las elecciones presidenciales de 2016, manipulando emociones y utilizando contenido provocador, de acuerdo con los perfiles psicológicos de cada usuario establecidos gracias a la información de Facebook (Garcia, 2023). Este incidente pone de manifiesto cómo la falta de regulación puede permitir que una empresa infrinja los derechos humanos e influya en la política. Por lo tanto, es esencial que los marcos regulatorios no solo proporcionen una guía para un uso ético de la IA, sino que también establezcan sanciones, deberes y responsabilidades entre empresas, usuarios y desarrolladores.

Se avanza en el año 2024, un momento crucial en el que las regulaciones establecidas durante el 2023 comienzan a tomar forma y a influir en el futuro de la IA a nivel mundial. Las leyes de seguridad de datos son un precedente importante para contextualizar la urgencia, así como los riesgos de la lentitud, la ineficacia y no aprender de los errores del pasado. La necesidad de regulaciones efectivas y anticipadas es más urgente que nunca. Como sociedad, se comparte la responsabilidad de las tecnologías y las regulaciones. Como ciudadanos, se debe informar y expresar las preocupaciones, respaldar y conocer esos esfuerzos jurídicos.

En conclusión, nos encontramos aún en las primeras etapas del desarrollo de la IA a nivel mundial. En ese contexto, es un momento oportuno para desarrollar diferentes estrategias y marcos legales que garanticen que las tecnologías basadas en IA se adhieran a las normas establecidas por la Ley. Los desafíos que implican el desarrollo de la IA con un enfoque en el ser humano no debe verse como un obstáculo. En cambio, se debe equilibrar los avances tecnológicos con la protección de los derechos humanos, logrando así un desarrollo que no suponga una infracción para los derechos fundamentales.

Referencias bibliográficas

- Barrera, V. (2024, enero 22). La IA Act: El primer marco normativo vinculante de la Inteligencia Artificial. Departamento de Derecho de las Telecomunicaciones de la Universidad Externado de Colombia. Blog Jurídico – TECH. https://www.ohchr.org/sites/default/files/Documents/Issues/Business/B-Tech/B_Tech_Project_revised_scoping_final.pdf

- Comisión Europea. (2023, diciembre 19). EU AI Act: first regulation on artificial intelligence The use of artificial intelligence in the EU will be regulated by the AI Act, the world’s first comprehensive AI law. Find out how it will protect you. European Parliament. https://www.europarl.europa.eu/pdfs/news/expert/2023/6/story/20230601STO93804/20230601STO93804_es.pdf

- Dressel, J. & Farid, H. (2018). The accuracy, fairness, and limits of predicting recidivism. Science Advances v4(1),1-5. https://www.science.org/doi/10.1126/sciadv.aao5580

- Duran, C. (2023). La importancia de la regulación de la inteligencia artificial en atención sanitaria y otros campos: lecciones desde Hollywood. Medicina general y de familia, v12(5): 195-196.http://dx.doi.org/10.24038/mgyf.2023.049

- Garcia, J. (2023, noviembre 24). ¿Hacia dónde vamos? América Latina ante la inteligencia artificial: mapeo de iniciativas regulatorias en la región. Rev. Derechos Digitales. https://www.derechosdigitales.org/22881/america-latina-ante-la-inteligencia-artificial-mapeo-de-iniciativas-regulatorias-en-la-region/

- Future of Life Institute (FLI). (2024, febrero 2). Ley de Inteligencia Artificial de la UE. https://artificialintelligenceact.eu/es/ai-act-explorer/

- Morales, C. (2020, septiembre 1). El impacto de la inteligencia artificial en la protección de datos personales. World Compliance Association. https://www.worldcomplianceassociation.com/2767/articulo-el-impacto-de-la-inteligencia-artificial-en-la-proteccin-de-datos-personales.html

- Morales, P. (2023). Índice Latinoamericano de Inteligencia Artificial (ILIA). Biblioteca del Congreso Nacional de Inteligencia Artificial de Chile. https://obtienearchivo.bcn.cl/obtienearchivo?id=repositorio/10221/34598/1/Indice_Latinoamericano_de_Inteligencia_Artificial.pdf

- Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO). (2021, noviembre 23). Recomendación sobre la ética de la inteligencia artificial. https://unesdoc.unesco.org/ark:/48223/pf0000381137_spa/PDF/381137spa.pdf.multi

- Parlamento Europeo, (2024). Resolución legislativa del Parlamento Europeo, sobre la propuesta de Reglamento del Parlamento Europeo y del Consejo por el que se establecen normas armonizadas en materia de inteligencia artificial (Ley de Inteligencia Artificial) y se modifican determinados actos legislativos de la Unión (COM(2021)0206 – C9-0146/2021 – 2021/0106(COD)) Reglamento de Inteligencia Artificial. https://www.europarl.europa.eu/doceo/document/TA-9-2024-0138-FNL-COR01_ES.pdf

- Veronese, A. & Nunes, A. (2021). Trayectoria normativa de la inteligencia artificial en los países de Latinoamérica con un marco jurídico para la protección de datos: límites y posibilidades de las políticas integradoras. Revista Latinoamericana de Economía y Sociedad Digital, Issue 2. https://revistalatam.digital/article/210207/